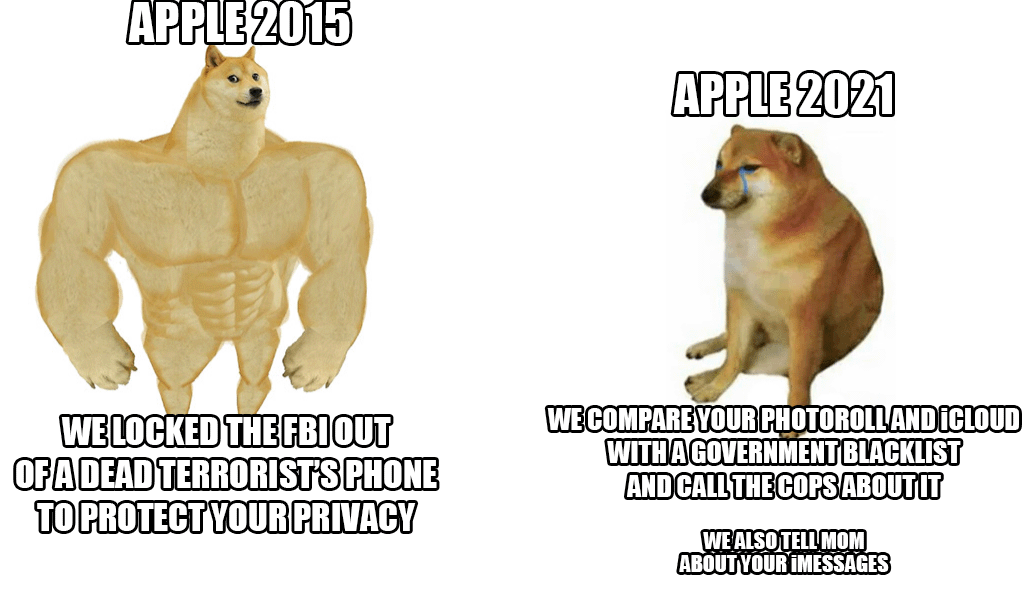

اواخر هفته گذشته، اپل از یک سیستم جدید ضد کودک آزاری رونمایی کرد که تقریباً عکس های iCloud همه را اسکن می کند. اگرچه این ایده در نگاه اول خوب به نظر می رسد، زیرا کودکان واقعاً باید از این اقدام محافظت شوند، غول کوپرتینویی با این وجود مورد انتقاد یک بهمن قرار گرفت - نه تنها از جانب کاربران و کارشناسان امنیتی، بلکه از طرف خود کارمندان.

طبق آخرین اطلاعات یک آژانس محترم رویترز تعدادی از کارمندان نگرانی های خود را در مورد این سیستم در یک ارتباط داخلی در Slack بیان کردند. گفته می شود، آنها باید از سوء استفاده احتمالی مقامات و دولت ها که می توانند از این امکانات سوء استفاده کنند، به عنوان مثال برای سانسور افراد یا گروه های منتخب بترسند. افشای این سیستم باعث ایجاد یک بحث قوی شد که در حال حاضر بیش از 800 پیام فردی در Slack فوق الذکر دارد. به طور خلاصه، کارمندان نگران هستند. حتی کارشناسان امنیتی قبلاً توجه خود را به این واقعیت جلب کرده اند که در دستان نادرست، این سلاح واقعاً خطرناکی است که برای سرکوب فعالان، سانسور ذکر شده آنها و موارد مشابه استفاده می شود.

خبر خوب (تا کنون) این است که این جدید فقط در ایالات متحده شروع خواهد شد. در حال حاضر، حتی مشخص نیست که آیا این سیستم در داخل کشورهای اتحادیه اروپا نیز مورد استفاده قرار خواهد گرفت یا خیر. با این حال، با وجود تمام انتقادات، اپل روی خود ایستاده و از سیستم دفاع می کند. او بیش از همه استدلال میکند که تمام بررسیها در دستگاه انجام میشود و هنگامی که یک تطابق وجود دارد، فقط در آن لحظه مورد دوباره توسط یک کارمند اپل بررسی میشود. تنها با صلاحدید وی به مراجع ذیربط تحویل داده می شود.

میتوانست باشد به شما علاقه مند است

من از اینکه از iCloud به چیزی امن و واقعا خصوصی تغییر کنم متنفرم، اما اگر اپل اصرار کند، به هر حال پرداخت به آنها را متوقف خواهم کرد.

(در حال حاضر) فقط در ایالات متحده فعال خواهد بود

واقعاً مهم نیست که کجا از نظر قانونی اعمال می شود. این فناوری قبلاً وجود دارد و به کار گرفته می شود. این بزرگترین خطر است.